これまでコンピューターやパソコン、ネットワークの進歩は、デバイス技術、特にマイクロプロセッサー(CPU)の技術に支えられてきました。もちろん、それ以外のメモリーや記憶装置などの進歩も貢献していますが、CPUが中心的役割を果たして来たのは間違いないでしょう。

現在は2-3Ghz程度のCPUが主流になっていますが、10Ghzや30GhzなどのCPUが登場するのも、そう先の事ではないと予想されます。

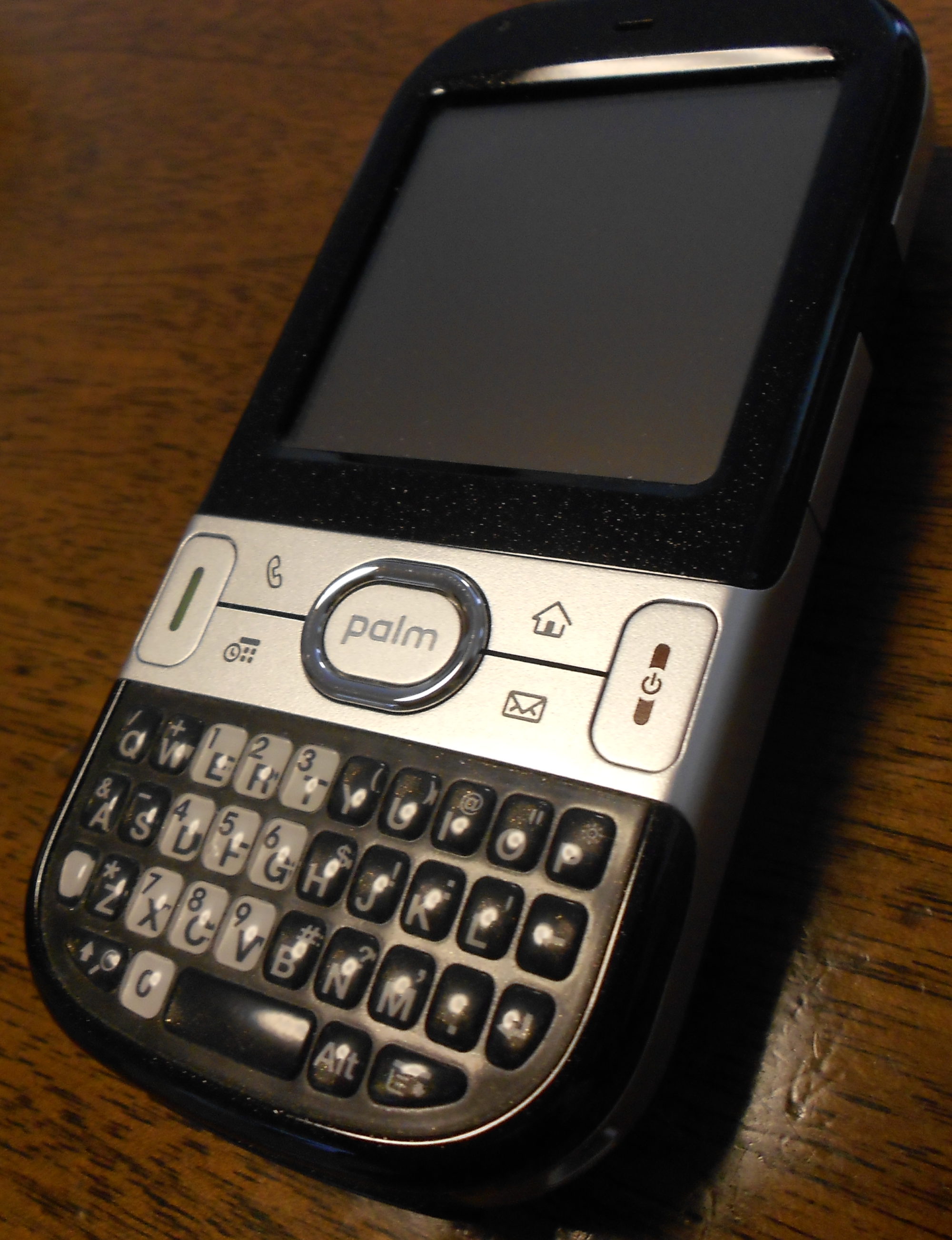

パームも同様に、以前より高速なCPUを搭載する機種が増えてきましたが、近い将来音声認識による自動翻訳等の用途に発展していくには、更に高速なCPUが要求されるでしょう。

もう2年も前の事になりますが、IEEEの会議でCPUの発熱を問題にしていた事がありました。これまでは、CPUの発熱量は単位面積当たりではせいぜいホットプレートと同じぐらいだったのが、近い将来原子炉の中の温度と同じになり、2010年には太陽の表面温度と同じになると言われていました。この温度の問題によりこれまでの技術の延長線上では、数十GhzのCPUを実現する事はできないため、インテルは新しいデバイス構造を提案していました。

また同じ会議で発表されたNECの資料によると、IT関連の機器による電力消費はこのまま増加していくと、日本だけで2010年には285Bwhになり、これは原子力発電所30基分に相当すると言われています。

過去に何度もシリコン半導体の限界説が唱えられては、新しい技術で打開してきましたが、今回の限界は打開していけるのでしょうか?あるいは打開すべきなのでしょうか?

また発熱以外にも眼界が近づいている問題があります。

半導体のプロセスが進歩すると、製造に必要なマスクのコストも増大し、最新のプロセスにはマスク一式で1億円かかるとも言われています。設計変更があればその都度必要になりますから、それなりの生産量が確保でき、コストを吸収できるものでなければ最新のプロセスを利用する事はできないでしょう。

また、数Ghzを超えるクロック周波数を使う場合、微細化された配線では減衰や遅延が大きくなりすぎて、デバイスのスイッチング速度に間に合わなくなってきており、これまでの微細化技術とは逆に、巨大配線プロセスなども開発が進んできています。配線の抵抗や浮遊容量を減らす為には、集積度を犠牲にしなければならなくなっています。

グリッドコンピューティング等で、CPUと電力の負荷を平準化する事で、これらの限界を補える可能性もあります。これだけで全ての問題を解決できる訳ではありませんが、ハードウェアをこれ以上肥大化していくのではなく、ソフトウェアによって効率よくハードウェアを活かしていく方法を、もっと考えなければいけないのではないでしょうか?私はソフトウェアの進化に大きな期待を寄せます。

ソフトウェアは利用技術と言われていますが、これまでは肥大化していくハードウェアを如何に使い切るかを重要視してきたように思います。ハードウェアの高速化・大容量化が前提であり、ソフトウェアそのものの基本的な部分は、あまり進歩してこなかったと言う事はないでしょうか?

これまでのようなハードウェアをどう使い切るかではなく、人が何を望んでいるか、つまり本当に人の役に立つ情報を(ハードウェアの肥やしでなく)処理できるソフトウェアが、必要になってきているのではないでしょうか?